初心者による初心者の為のTensorFlowを使用したMNIST for ML Beginnersを解説。

はじめに

MNISTとは

TensorFlowの処理の流れ

- TensorFlow読み込み

- 式を立てる(モデル)

- セッションを開始

- 式を実行(run)

機械学習の3ステップ

- 現象をモデル化する

- モデルを最適化するパラメータを求める

- 学習したモデルを使用して推定・分類

このチュートリアルで何をするか

実装

from tensorflow.examples.tutorials.mnist import input_datamnist = input_data.read_data_sets("MNIST_data/", one_hot=True)

import tensorflow as tf

x = tf.placeholder(tf.float32, [None, 784])

placeholder(shape=None, #与えられる行列の形状(オプション)。形状が指定されていない場合は、任意の形状のテンソルを供給することができます。name=None #操作の名前(オプション)。)

次に、変数を定義。

W = tf.Variable(tf.zeros([784, 10]))b = tf.Variable(tf.zeros([10]))

y = tf.nn.softmax(tf.matmul(x, W) + b)

y_ = tf.placeholder(tf.float32, [None, 10])

cross_entropy = tf.reduce_mean(-tf.reduce_sum(y_ * tf.log(y), reduction_indices=[1]))

train_step = tf.train.GradientDescentOptimizer(0.5).minimize(cross_entropy)

https://www.tensorflow.org/api_guides/python/train#optimizers

)sess = tf.InteractiveSession()tf.global_variables_initializer().run()

for _ in range(1000):batch_xs, batch_ys = mnist.train.next_batch(100)sess.run(train_step, feed_dict={x: batch_xs, y_: batch_ys})

correct_prediction = tf.equal(tf.argmax(y,1), tf.argmax(y_,1))

accuracy = tf.reduce_mean(tf.cast(correct_prediction, tf.float32))

print(sess.run(accuracy, feed_dict={x: mnist.test.images, y_: mnist.test.labels}))

だがしかしこれはまだ深層学習ではない

TensorFlowで学ぶディープラーニング入門 ~畳み込みニューラルネットワーク徹底解説~

- 作者: 中井悦司

- 出版社/メーカー: マイナビ出版

- 発売日: 2016/09/27

- メディア: 単行本(ソフトカバー)

- この商品を含むブログ (1件) を見る

最後に

Is that good? Well, not really. In fact, it's pretty bad. This is because we're using a very simple model. With some small changes, we can get to 97%. The best models can get to over 99.7% accuracy!

そういや今年の6月は雨が少ないですね。

初心者による初心者の為のTensorFlowを使用したHello,Worldまでを解説してみるって話。

TensorFlowで学ぶディープラーニング入門?畳み込みニューラルネットワーク徹底解説

- 作者: 中井悦司

- 出版社/メーカー: マイナビ出版

- 発売日: 2016/09/28

- メディア: Kindle版

- この商品を含むブログを見る

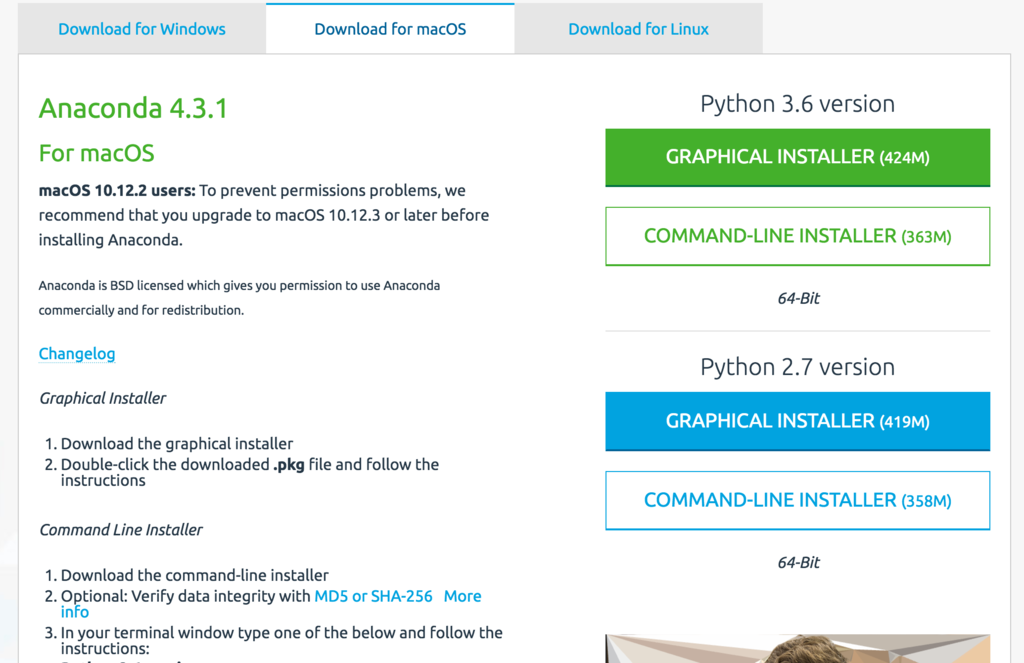

環境

TensorFlowとは

Anacondaとは

The Anaconda installation is community supported, not officially supported.

Tensorflowの導入

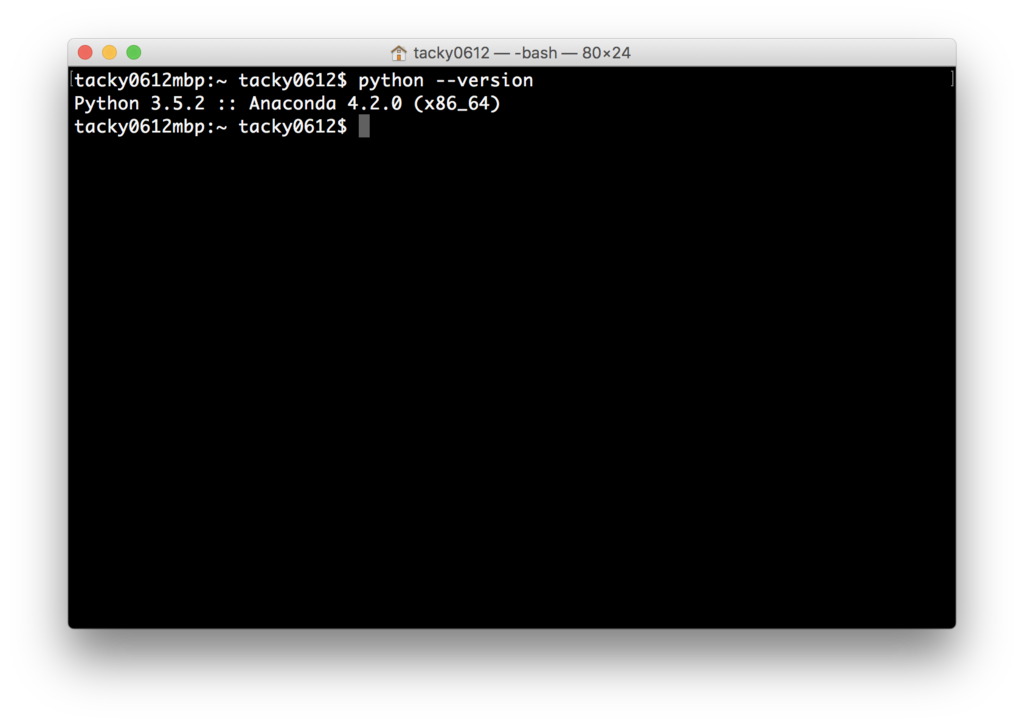

$ python —version

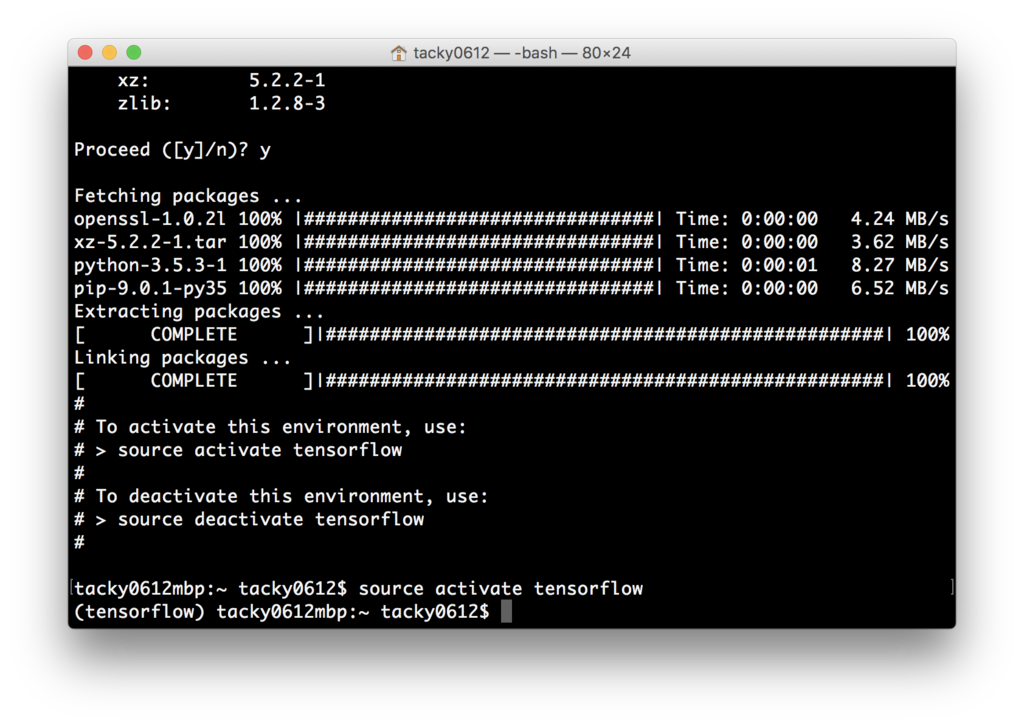

$ conda create -n tensorflow python=3.5

$ source activate tensorflow

必要なライブラリのインストール

$ conda install -c conda-forge tensorflow

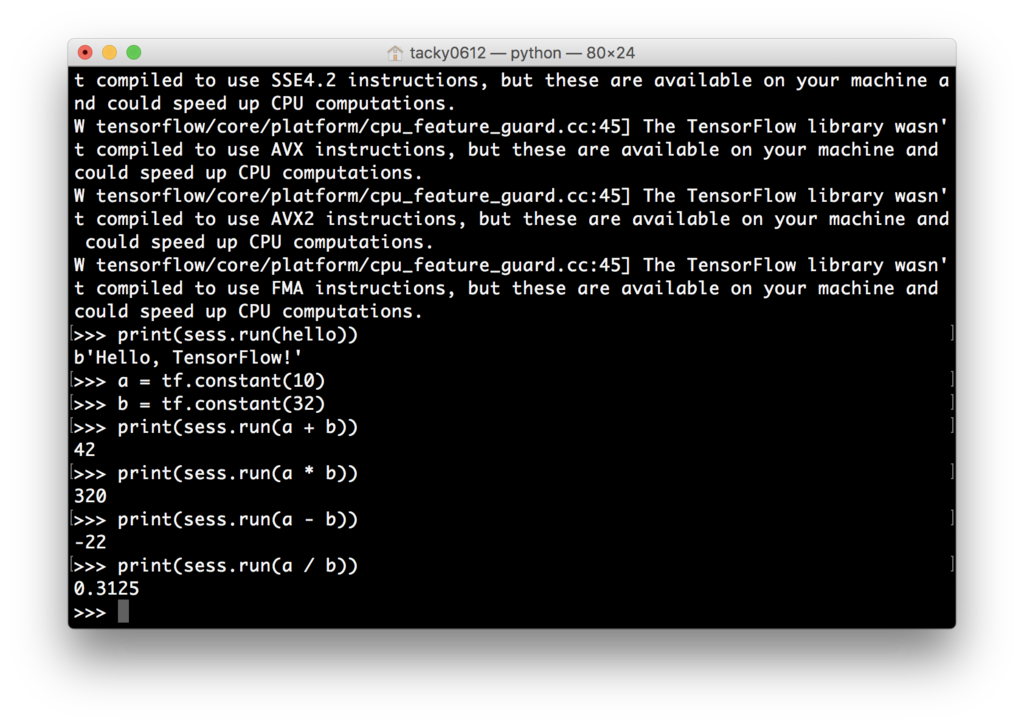

いよいよTensorflowで”Hello, world!”

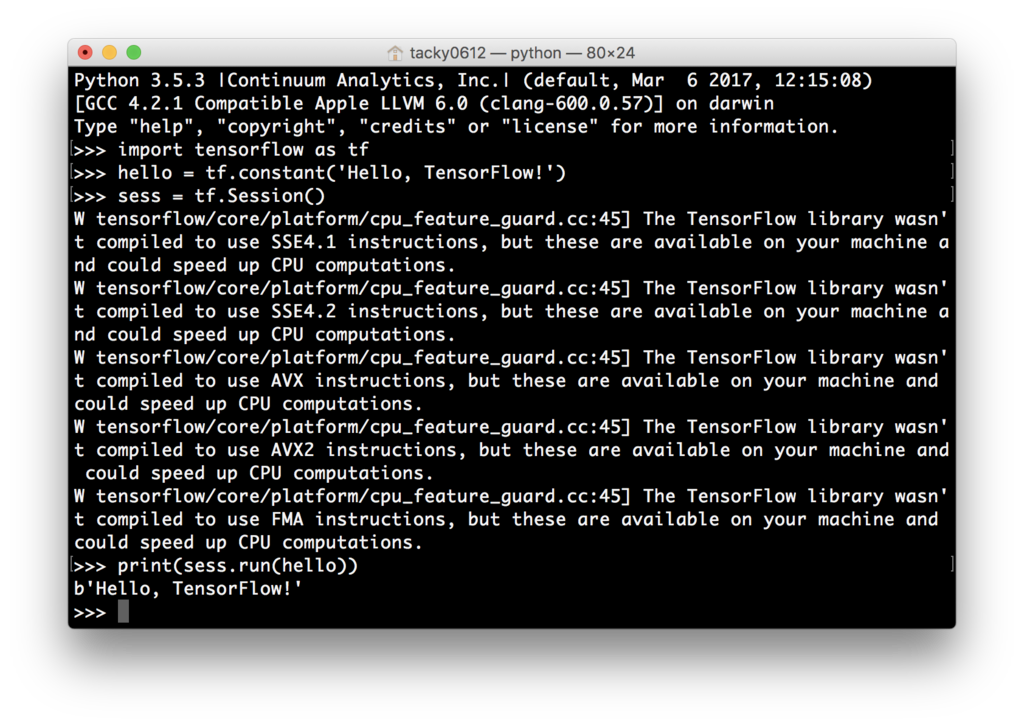

$ python

>>> import tensorflow as tf

>>> hello = tf.constant('Hello, TensorFlow!')

>>> sess = tf.Session()

>>> print(sess.run(hello))

W tensorflow/core/platform/cpu_feature_guard.cc:45] The TensorFlow library wasn't compiled to use SSE4.1 instructions, but these are available on your machine and could speed up CPU computations.

W tensorflow/core/platform/cpu_feature_guard.cc:45] The TensorFlow library wasn't compiled to use SSE4.2 instructions, but these are available on your machine and could speed up CPU computations.

W tensorflow/core/platform/cpu_feature_guard.cc:45] The TensorFlow library wasn't compiled to use AVX instructions, but these are available on your machine and could speed up CPU computations.

W tensorflow/core/platform/cpu_feature_guard.cc:45] The TensorFlow library wasn't compiled to use AVX2 instructions, but these are available on your machine and could speed up CPU computations.

W tensorflow/core/platform/cpu_feature_guard.cc:45] The TensorFlow library wasn't compiled to use FMA instructions, but these are available on your machine and could speed up CPU computations.

折角なので、簡単な四則演算も実行してみる

>>> a = tf.constant(10)

>>> b = tf.constant(32)

>>> print(sess.run(a + b))

>>> print(sess.run(a * b))

>>> print(sess.run(a - b))

>>> print(sess.run(a / b))

はい、想定通りですね。

終了方法

>>> exit()

$ source deactivate tensorflow

最後に

ゼロから作るDeep Learning ―Pythonで学ぶディープラーニングの理論と実装

- 作者: 斎藤康毅

- 出版社/メーカー: オライリージャパン

- 発売日: 2016/09/24

- メディア: 単行本(ソフトカバー)

- この商品を含むブログ (15件) を見る

詳解 ディープラーニング ~TensorFlow・Kerasによる時系列データ処理~

- 作者: 巣籠悠輔

- 出版社/メーカー: マイナビ出版

- 発売日: 2017/05/30

- メディア: 単行本(ソフトカバー)

- この商品を含むブログを見る

呟き。

Pyてょnのイメージって蛇のアイコンだし、インタラクティブシェルで実行してると蛇使いになった気分になれる(厨二)

— たっきー.py (@tacky0612) 2017年5月30日

奈良先端科学技術大学院大学のオープンキャンパスに行ってきた話。

どうもこんにちは。たっきーです。

5/13(土)に開催された奈良先端科学技術大学院大学のオープンキャンパスに行って刺激を受けてきたのでそのことについて書きます。

以下、個人的な見解と偏見。情報は執筆時点でのもの。

奈良先端科学技術大学院大学とは

英語名はNara Institute of Science and Technology。略してNAIST。

国立大学法人である。

特徴としては、

・学部がなく大学院のみある大学

・情報科学研究科・バイオサイエンス研究科・物質創成科学研究科から成る理THE系。

・学生数に対して教員の数が多い。

今回僕が見学してきたのは情報科学研究科である。

いいと思った点

・やりたい研究に没頭できる。

田舎に立地してある。故に周りに誘惑するものがない。故に研究に没頭できる。Let's ラボ畜。

・いろんな大学や高専出身の人がいる。

割合としてはやはり近畿圏の学生が多いが、いろんな地方から学生がやってくる。留学生も多い。しかし理系ということもあって女子学生が少ない。なんなら留学生のほうが女子学生よりも多いぐらい。

あと、文系出身や他学部出身の人も多いみたいで色んな視点から研究へアプローチをかけられるチームが形成されるってのは良いことなんじゃないかな。

・学部生がいないので一人あたりのスペースが広い。

結構広いなと思った。しかも生徒数が1000人ほどなので学生一人あたりのスペースが広い。

・校舎が綺麗

めっちょ綺麗だった。建物内も明るくて清潔感があり、トイレも綺麗だった。

そして各階エレベータ前には謎の円弧型の壁(柱?)がある。

・潤沢な研究機材。

いろんな研究機関とかと連携してたり、研究成果のライセンス料やらでめちゃめちゃお金あるみたい。

・国立大学なので学費が安い。

入学料282,000円、授業料年額535,800円と国立大学のスタンダードな値段。

私立に比べてとてもお安い。

悪いと思った点

・田舎である。

山の中に大学があるとは前々から聞いていたが、田舎である。

ちょっと何処かに買い物しに行きたいってなると足がないとちょっとつらいかも。

最寄り駅まで徒歩20分という。高校生時代を思い出す。

研究環境は素晴らしいのに生活環境はシティボーイには悪い。

ちなみに大阪難波まで電車で1時間ほどで行ける…。

でも、田舎生まれ田舎育ちの僕からしたら都会は窮屈なのであまりマイナス点ではない。

・知名度が低い。

NAIST、もとい奈良先端科学技術大学院大学。名前の雰囲気としてはF欄っぽい名前である。知名度が低くネームバリューは弱い。僕の友達で、奈良に住んでいてNAISTからも車で20分圏内に住んでいる大学生ですら認知していなかった。そもそも大学院しかないのでその分、知名度が低い。

ただ、情報系の分野において知名度は高いような気がします。僕の研究室の先生も評価していて、ニューラルネットの論文とか読んでるとたまーに名前を見かける。

・学生宿舎がボロい。

外見的には綺麗だけど、いざ門をくぐり抜けるとボロい。壁とか黒ずんでる箇所がちらほら。潔癖症ではないが、生活の拠点が綺麗でないのはあまりいただけない。あと、トイレと風呂がフロアで共用である。

あと、とても狭い。13m^2しかない。

しかし、家賃は光熱費込で1万ととても安いらしい。

・課外活動が少ない。

課外活動が少ない。(公式の課外活動が少ないだけで有志でやってる団体もいるかも…?)

まぁ院生だけだしそんな課外活動に従事する暇ないか。

気になった研究を3つ

全部の研究を見てきたわけではないが、個人的に気になった、印象的だった研究について書く。多くを語りすぎると間違いを言ってしまう気しかしないので簡潔に。

・多重高周波照明による半透明物体内部のスライス可視化

文献が転がってたので貼っておきます↓

http://omilab.naist.jp/~mukaigawa/papers/CVIM2015-MFI.pdf

私達が絵画を見る時は完成した形の絵しか見れないが、この手法ではカメラとか光の反射とかの特性をうまく利用して下書きまで見ることができるという研究。デモをしていただいたがすごかった(語彙)

あと、この光メディアインターフェース研究室、めっちゃおしゃんだった。カメラもレンヅもいっぱい転がってあった。よき。

・カメラ画像から制御則を学習する新しい深層強化学習アルゴリズムを開発

産業用双腕ロボットのNextageってのを使って布をうまくひっくり返すという研究。地味だけどすごい。

ランダムに布をロボットが動かし、そのパターンを機械学習にぶちこみ学習させ、どう動かせば最小の動作で布をひっくり返せるかを人工知能が判断する。

ちなみにロボットアームからのフィードバックを得て制御しているわけではなく、センシングはカメラのみらしい。すごいぞ知能システム制御研究室。

・Visuo-Hapticシステム

いわゆるMRってやつ、HMDをかけると対象物が見れ天井からぶら下がったスティックでCGに触れると触った感覚がリアルに伝わってくるというやつ。

視覚的情報だけでなく、触覚的情報も支配されてる感じがあった。一般家庭とかでも扱える形まで持っていけるとゲームとかすごく面白くなりそう。

感想

第一印象としては”校舎がとても綺麗”。

めちゃ綺麗だった。あと広いし明るいしおしゃん。

建物の階段の色だが、情報科学研究科が赤、

ところで大学のオープンキャンパスっていっぱいあるけどさ、大学院のオープンキャンパスってすくないよな…。

僕は高校生の時に大阪大学、名古屋工業大学、三重大学のオープンキャンパスに遊びに行ったことあるけど、他人の研究とか見ててすごい刺激的だし大学院志望の学生に向けてのオープンキャンパスをもっと開いてほしいなと感じました。

ここで受けた刺激を燃料に僕も研究頑張ります。

面白いなと思ったNAIST紹介↓

悪ノリでOC後に大阪寄ってきました

これ、僕です🙌🙌🙌

— たっきー (@tacky0612) 2017年5月13日

大阪なう🙌🙌🙌

I LOVE TENGA💃💃💃 pic.twitter.com/9S3Z4uhl8z